没收到验证邮件?请确认邮箱是否正确或 重新发送邮件

#本文由作者授权发布,不代表IPRdaily立场,未经作者许可,禁止转载#

“DeepSeek一方面将大模型代码及训练文档全面开源,另一方面通过专利壁垒守护关键技术。”

来源:IPRdaily中文网(iprdaily.cn)

作者:佑斌

近日,中国AI企业深度求索(DeepSeek)在人工智能领域掀起技术风暴。其研发的大语言模型在多项基准测试中表现惊艳,不仅比肩或超越欧美顶尖模型,更以低一个数量级的训练成本实现这一突破。这场技术地震正在动摇AI发展范式——DeepSeek以超低成本实现超强性能的表现,直接挑战了行业对“大算力=高性能”的传统认知,甚至引发连锁反应:以英伟达为代表的AI芯片巨头股价应声下跌,市场开始重新评估算力军备竞赛的商业逻辑。

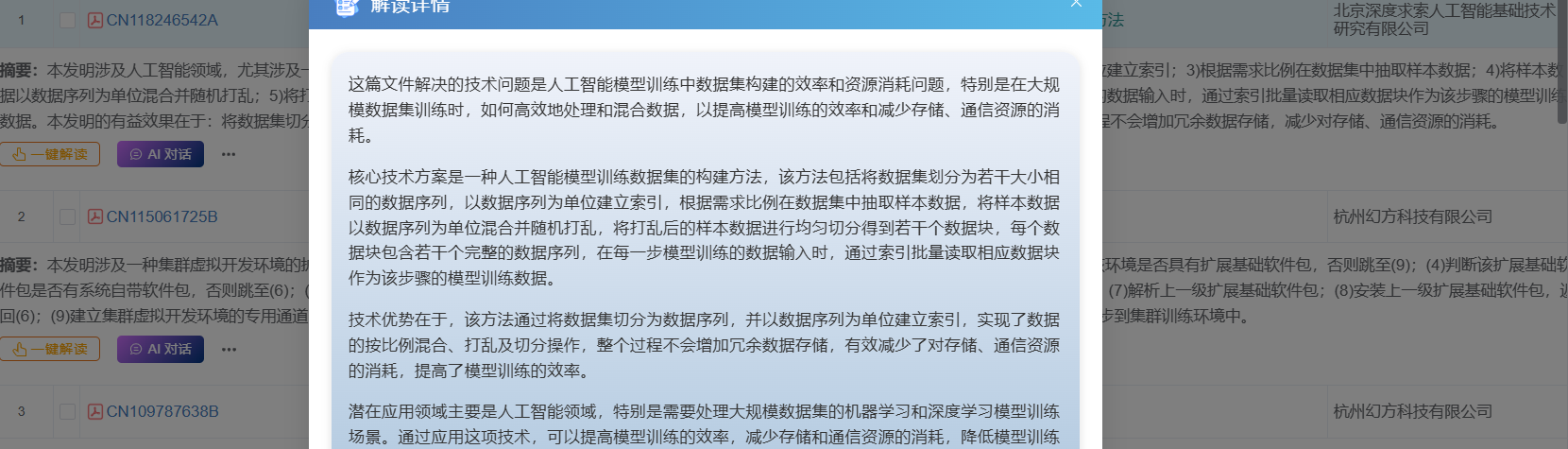

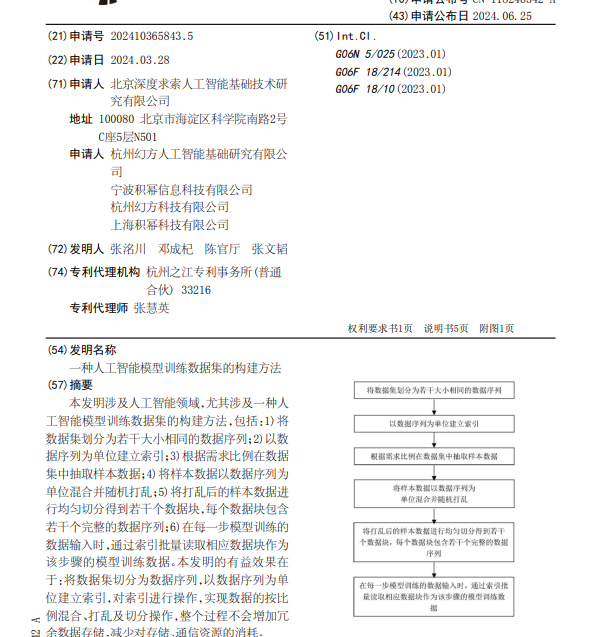

值得关注的是,DeepSeek一方面将大模型代码及训练文档全面开源,另一方面通过专利壁垒守护关键技术。从AI专利分析平台Maxipat检索可见,其核心技术专利并未直接归属运营主体,而是分散布局于北京深度求索人工智能基础技术研究有限公司、杭州幻方系公司(幻方科技/幻方人工智能基础研究院)及宁波积幂信息科技等关联企业。最新披露的专利CN118246542A,“人工智能模型训练数据集的构建方法”,正是通过独创的数据序列索引技术,实现了训练数据存储与通信资源消耗量级下降,这或许正是其极致性价比的底层密码。

从Maxipat的AI对话和解读中可以获知:

这项专利解决的技术问题是人工智能模型训练中数据集处理效率低下和资源消耗较大的问题,特别是在大规模数据集训练时,数据的混合、打乱及切分操作会导致存储和通信资源的大量消耗。

核心技术方案是一种人工智能模型训练数据集的构建方法,该方法包括将数据集划分为若干大小相同的数据序列,以数据序列为单位建立索引,根据需求比例抽取样本数据,将样本数据以数据序列为单位混合并随机打乱,将打乱后的样本数据进行均匀切分得到若干个数据块,每个数据块包含若干个完整的数据序列,以及在每一步模型训练的数据输入时,通过索引批量读取相应数据块作为该步骤的模型训练数据。

技术优势在于,该方法通过将数据集切分为数据序列,并以数据序列为单位建立索引,实现了数据的按比例混合、打乱及切分操作,整个过程不会增加冗余数据存储,从而有效减少了对存储、通信资源的消耗,提高了数据处理的效率和模型训练的性能。

Maxipat的AI对话和解读

主要作用如下:

减少存储与通信开销:通过索引管理数据序列(而非物理修改数据),显著降低冗余数据存储需求,节省存储硬件成本(如SSD、内存占用)。异步I/O和批量读取优化了数据传输效率,减少网络带宽和存储I/O的压力,间接降低分布式训练中的通信成本。

提升GPU利用率:高效的数据加载(如异步I/O)减少了GPU等待数据的空闲时间,使GPU更专注于计算任务,提高单位GPU的利用率。数据预处理(混合、打乱、切分)通过逻辑操作完成,无需额外计算资源,减少对CPU或辅助硬件的依赖,释放资源供GPU使用。

缩短训练周期:数据准备效率的提升(如快速采样、动态调整比例)加速了迭代实验过程,缩短整体训练时间。在相同时间内,用更少的GPU即可完成原定任务,或更快释放GPU资源供其他任务使用。

支持轻量化训练流程:通过逻辑索引管理,无需大规模数据复制或重组,降低对高性能存储设备的依赖,使训练任务可在成本更低的硬件环境中运行。

除北京深度求索人工智能基础技术研究有限公司外,杭州幻方人工智能基础研究有限公司、宁波积幂信息科技有限公司、杭州幻方科技有限公司、上海积幂科技有限公司等关联企业累计公开16项核心技术专利,其中多项聚焦于大模型训练效率提升与系统稳定性优化。例如公开号CN112925640B,主题为一种集群训练节点分配方法、电子设备,解决的技术问题是在集群训练节点分配领域中存在的资源利用率低和训练任务报错率高的问题,特别是在大规模机器学习训练任务中,如何高效地分配计算资源以减少任务的总体报错率和故障率。CN118503194A,主题为一种多GPU集群网络的RDMA并行数据传输方法,CN118075198A,主题为一种高速网络拓扑结构路径规划的方法及设备,解决的技术问题是大规模集群和分布式训练场景中网络拥塞导致GPU算力失效的问题。

从deepseek披露的专利,我们通过Maxipat可以清晰梳理出其技术路线。

技术点1:网络与硬件优化

多平面RDMA通信(CN118612157A):跨节点GPU直连,减少CPU依赖。胖树网络拓扑拆分(CN118250215A):逻辑分块优化路径,降低拥塞。多GPU动态调度(CN114780203A):席位机制管理资源,避免冲突。网络吞吐量提升,支持万卡级集群训练。硬件利用率提高,故障率降低大幅度降低。

技术点2:数据存储与处理

分布式异步IO存取(CN117707416A):分片存储+并行读取,IO效率提升。无损压缩技术(CN109787638B):动态压缩策略,存储成本减少。智能数据集构建(CN118246542A):数据序列索引抽样,冗余数据趋零。实现PB级数据加载速度提升,支持千亿参数模型训练。

技术点3:分布式训练框架

异构断点续训(CN117669701A):虚拟模型参数兼容不同并行策略。多GPU轮询通信(CN118612158A):均衡网络负载,带宽利用率提高。动态任务调度(CN114138441B):优先级+用户权益多维度分配算力。实现千亿模型训练效率提升,中断恢复时间缩短至分钟级。

技术点4:开发效率提升

云原生开发环境(CN115061725B):环境一键同步,开发到训练无缝衔接。长链接容错机制(CN116032999A):动态重连策略,通信稳定性99.99%。实现开发效率提升,支持AI+行业场景快速落地。

从底层网络优化到上层应用落地,该公司通过高速通信、智能调度、高效数据工程、弹性训练框架,构建了面向大语言模型的“端到端”技术体系,实现低成本、高可靠、超大规模的大语言模型的基础设施能力。

所以冰冻三尺非一日之寒,Deepseek取得今天的成就并不是一蹴而就,而是长期的专注的研发的体现,相比对于很多大厂,Deepseek虽然是小公司,但对大语言模型的投入和技术研发的深度并不逊色。

(原标题:Deepseek的专利揭秘,为什么能够引爆AI界?)

来源:IPRdaily中文网(iprdaily.cn)

作者:佑斌

编辑:IPRdaily辛夷 校对:IPRdaily纵横君

注:原文链接:Deepseek的专利揭秘,为什么能够引爆AI界?(点击标题查看原文)

「关于IPRdaily」

IPRdaily是全球领先的知识产权综合信息服务提供商,致力于连接全球知识产权与科技创新人才。汇聚了来自于中国、美国、欧洲、俄罗斯、以色列、澳大利亚、新加坡、日本、韩国等15个国家和地区的高科技公司及成长型科技企业的管理者及科技研发或知识产权负责人,还有来自政府、律师及代理事务所、研发或服务机构的全球近100万用户(国内70余万+海外近30万),2019年全年全网页面浏览量已经突破过亿次传播。

(英文官网:iprdaily.com 中文官网:iprdaily.cn)

本文来自IPRdaily中文网(iprdaily.cn)并经IPRdaily.cn中文网编辑。转载此文章须经权利人同意,并附上出处与作者信息。文章不代表IPRdaily.cn立场,如若转载,请注明出处:“http://www.iprdaily.cn

共发表文章7509篇

共发表文章7509篇文章不错,犒劳下辛苦的作者吧

- 我也说两句

- 还可以输入140个字